阿里通义Qwen团队发布了新模型Qwen3-30B-A3B-Thinking-2507,这是一个中等规模的MoE模型,专注于提升“思考”能力。

该模型在过去三个月中持续优化,显著增强了推理的质量和深度。模型的主要亮点包括:

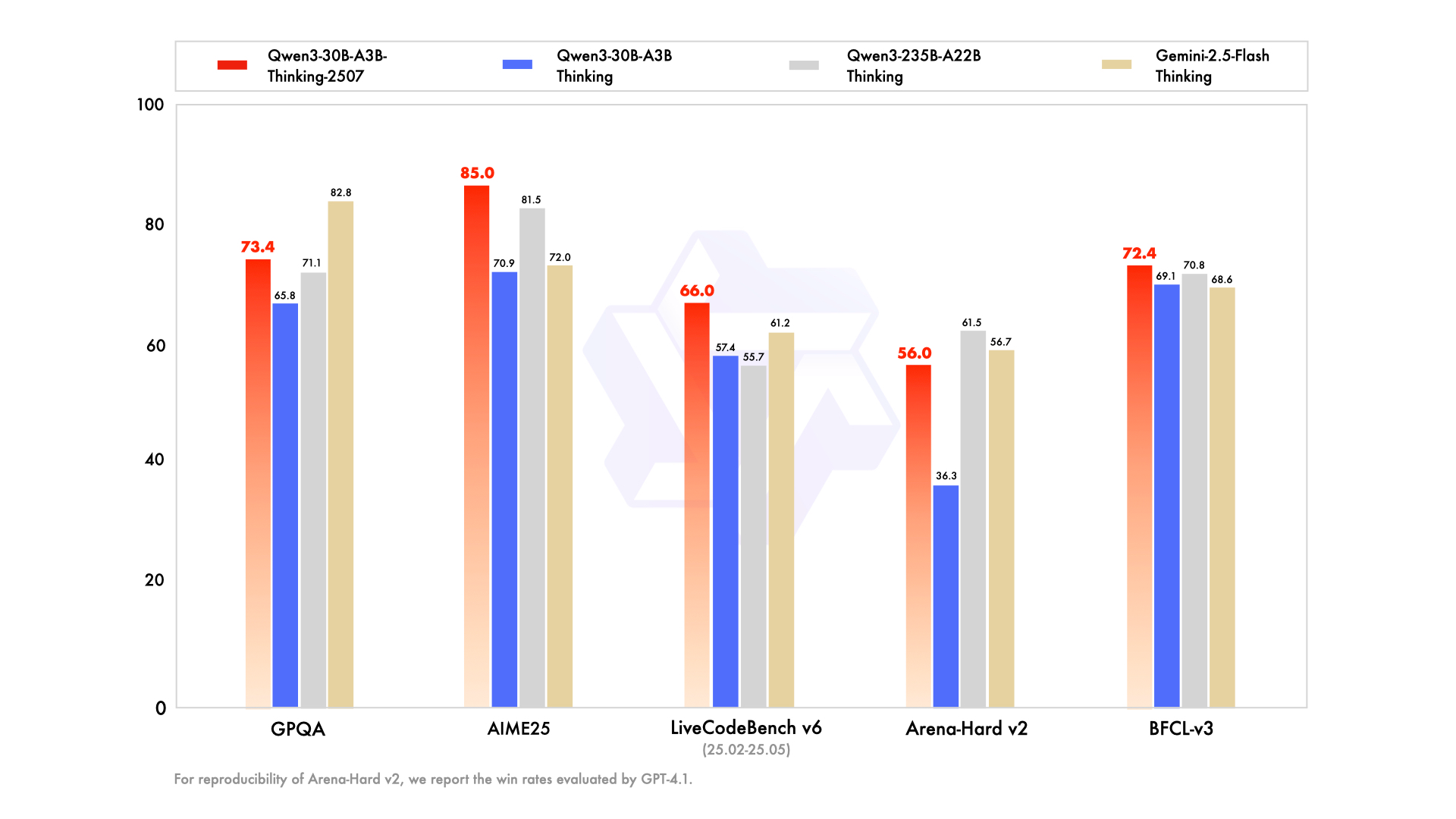

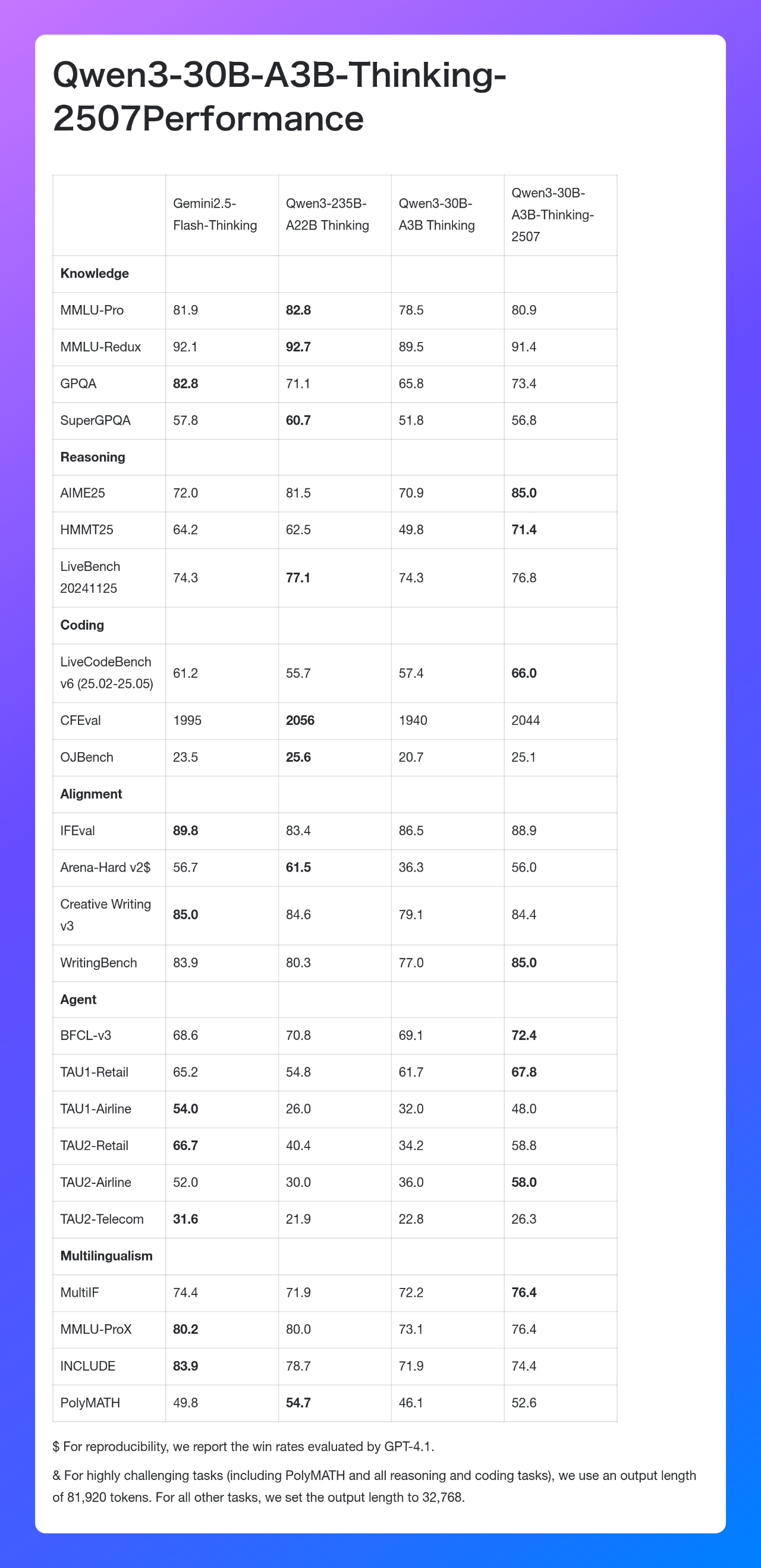

根据官方发布的性能数据,该模型在AIME25、HMMT25和LiveCodeBench等多个高难度推理和编码基准测试中取得了优异成绩,部分指标甚至超过了Gemini-2.5-Flash-Thinking和Qwen3-235B-A22B Thinking。

Qwen3-30B-A3B-Thinking-2507是一个拥有305亿总参数和33亿激活参数的Causal Language Model,原生支持262,144 tokens的上下文长度。该模型仅支持思考模式,并且默认的聊天模板会自动包含<think>标签以强制模型进行思考。

模型已在Hugging Face和ModelScope上开放,并可在 Qwen Chat 上体验。

还没有评论,来说两句吧...