阅读《2024 中国开源开发者报告》赢大奖,扫码申请享特权

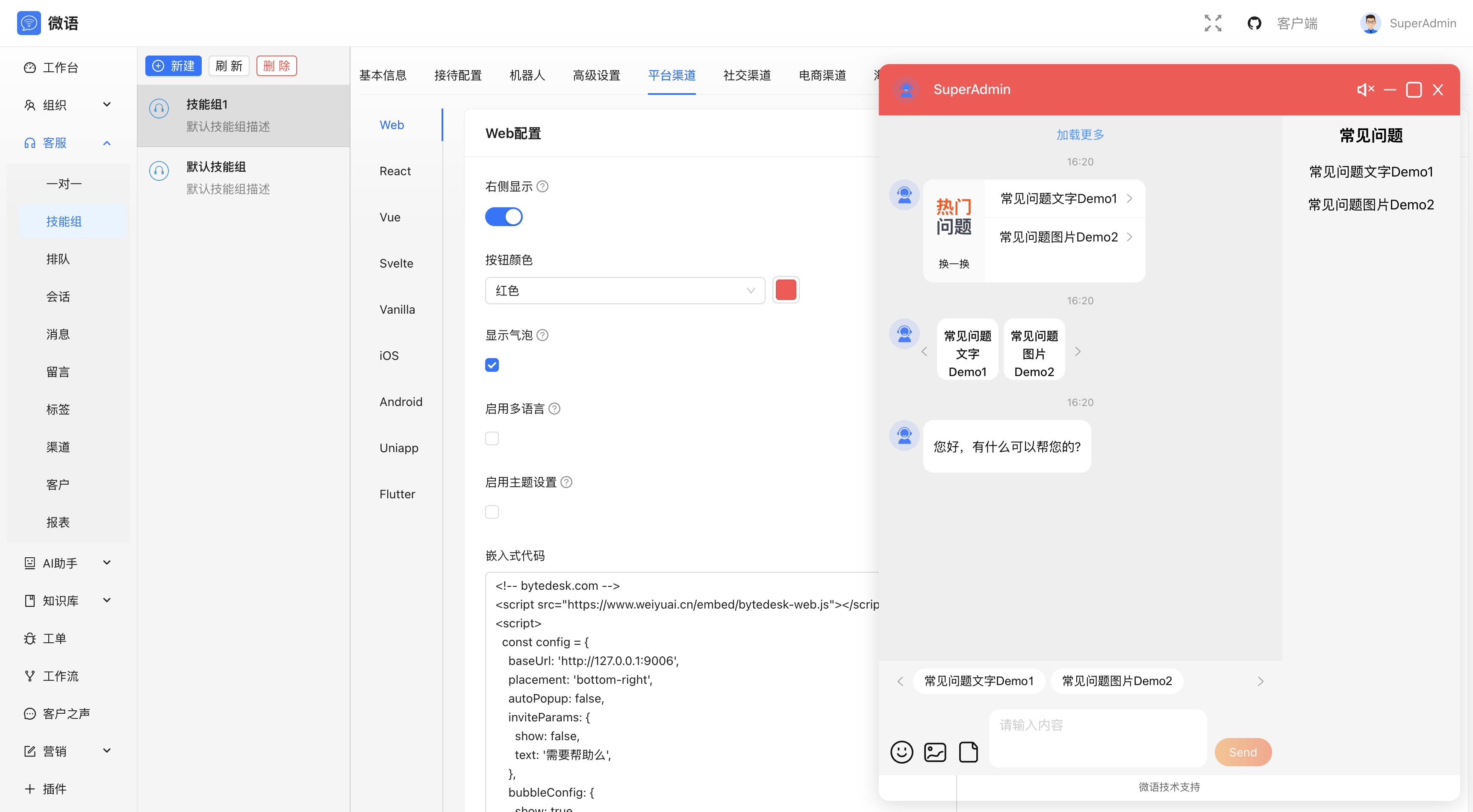

企业级多租户即时通讯解决方案,免费开源8件套:企业IM、在线客服、企业知识库、帮助文档、工单系统、AI对话、项目管理、工作流。

:::tip 微语仍处于早期的快速迭代阶段,文档可能落后于开发,导致功能描述可能不符,以最新发布的软件版本为准 :::

语言

- English

- 中文

介绍

企业IM

- 局域网即时通讯

- 企业成员管理

- 聊天记录监控

- ...

全渠道客服

- 多渠道接入

- 人工客服

- 统计报表

- ...

知识库

- 对接大模型L

- 自定义知识库

- AI对话

- ...

工单系统

- 工单管理

- 工单SLA管理

- 工单统计和报表

- ...

AI 大模型

- Ollama/DeepSeek/ZhipuAI/...

- 智能体

- 工作流

- ...

社交群组

- 类似 Discord

- ...

多租户

- 多租户管理

- 租户隔离

- 租户统计

- ...

Docker 快速开始

方法一:克隆项目并启动docker compose容器,需要另行安装ollama,默认使用 qwen2.5:1.5b 模型

git clone https://gitee.com/270580156/weiyu.git && cd weiyu/deploy/docker && docker compose -p weiyu -f docker-compose.yaml up -d 因项目默认使用ollama qwen2.5:1.5b模型,所以需要提前拉取模型

ollama pull deepseek-r1:1.5b ollama pull qwen2.5:1.5b 或者 方法二:使用 docker compose ollama,默认安装ollama,默认使用 qwen2.5:1.5b 模型

git clone https://gitee.com/270580156/weiyu.git && cd weiyu/deploy/docker && docker compose -p weiyu -f docker-compose-ollama.yaml up -d # 运行模型 docker exec ollama-bytedesk ollama pull deepseek-r1 docker exec ollama-bytedesk ollama pull qwen2.5:1.5b 如果不需要知识库AI问答功能,可以修改 docker-compose.yaml 或 docker-compose-ollama.yaml 关闭ollama对话和嵌入功能,以节省资源

# 关闭ollama对话 SPRING_AI_OLLAMA_CHAT_ENABLED: false # 关闭ollama嵌入 SPRING_AI_OLLAMA_EMBEDDING_ENABLED: false 停止容器

docker compose -p weiyu -f docker-compose.yaml stop 修改配置,否则上传图片、文件和知识库无法正常显示

- 修改

docker-compose.yaml文件 或docker-compose-ollama.yaml文件,修改以下配置项:

# 请将服务器127.0.0.1替换为你的服务器ip BYTEDESK_UPLOAD_URL: http://127.0.0.1:9003 BYTEDESK_KBASE_API_URL: http://127.0.0.1:9003 方法三:宝塔面板

- 宝塔面板部署

演示

本地预览

# 请将127.0.0.1替换为你的服务器ip http://127.0.0.1:9003/ # 开放端口:9003, 9885 - 线上预览

- demo

开源客户端

- 桌面客户端

- 移动客户端

开源SDK

链接

- 下载

- 文档

技术栈

- springboot-3.x for 后端

- react for web前端

- flutter for 移动客户端(ios&android)

- electron for 桌面客户端(windows&mac&linux)

还没有评论,来说两句吧...